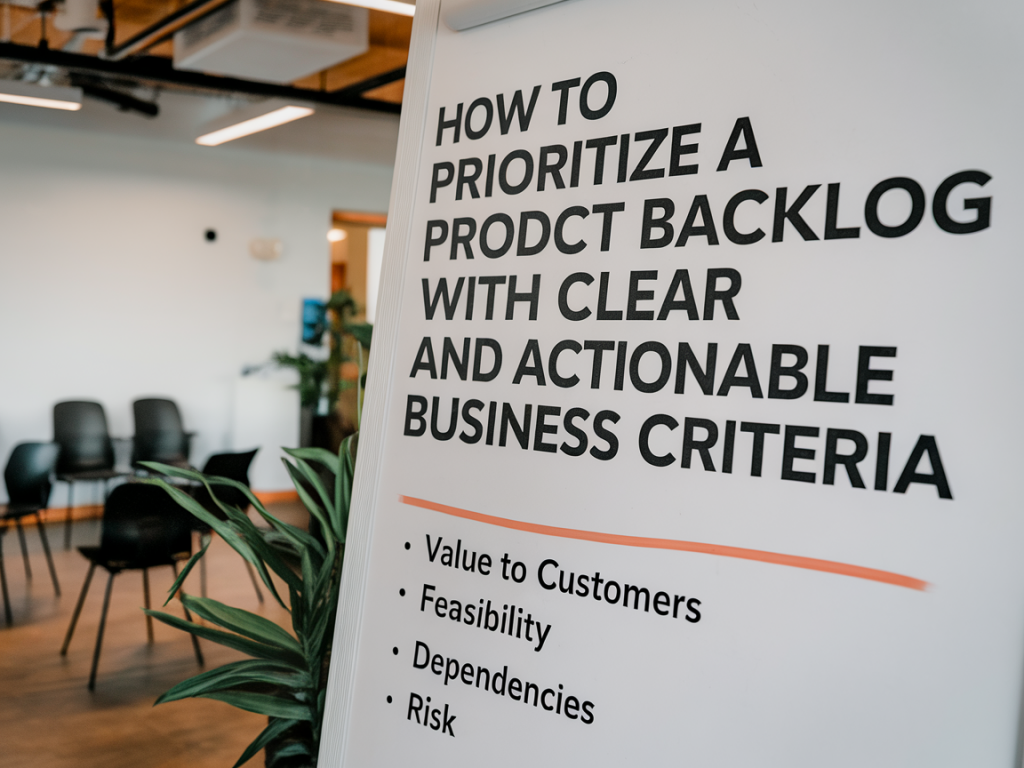

Prioriser un backlog produit, c’est souvent moins une question de méthode magique qu’un exercice de clarté : quels objectifs business on sert, quelles incertitudes on réduit, et quels compromis on est prêt à accepter. J’ai passé des années à affiner des approches pragmatiques — entre frameworks comme RICE ou WSJF, réunions d’équipe et arbitrages avec les parties prenantes — et je partage ici une méthode simple, basée sur des critères business clairs et actionnables, que j’utilise pour rendre les décisions reproductibles et défendables.

Pourquoi formaliser des critères business ?

J’ai vu trop d’équipes se laisser happer par l’urgence des tickets ou par la voix la plus forte en réunion. Sans critères partagés, la priorisation devient arbitraire et difficile à expliquer aux dirigeants ou aux clients. Formaliser des critères permet :

Les critères business que j’utilise

Voici une liste de critères simples et actionnables — je les combine souvent, selon le contexte produit :

Un cadre simple et reproductible : score pondéré

Pour rendre les décisions concrètes, je calcule un score pondéré. Chaque critère reçoit un poids (selon vos priorités) et une note (1–5). Le score final = somme(note × poids). Exemple de pondération que j’utilise souvent pour un produit SaaS :

| Critère | Poids | Notes (1–5) |

|---|---|---|

| Impact sur les objectifs | 0.30 | |

| Valeur client | 0.25 | |

| Effort | 0.20 | |

| Confiance / Risque | 0.15 | |

| Dépendances / Technique | 0.10 |

Exemple d’application : une feature A pourrait obtenir Impact 4, Valeur client 5, Effort 3, Confiance 4, Dépendances 3 → Score = 4×0.30 + 5×0.25 + 3×0.20 + 4×0.15 + 3×0.10 = 3.7. Une feature B avec plus d’effort et moins d’impact aura un score inférieur.

Intégrer Cost of Delay (CoD) et WSJF quand c’est pertinent

Pour les organisations qui ont besoin d’un angle plus financier ou temporel, j’intègre parfois le Cost of Delay et le WSJF (Weighted Shortest Job First) :

Ce modèle force à traduire l’impact en valeur commerciale — ce n’est pas toujours facile mais c’est puissant pour discuter avec le management ou le sales.

Atelier de priorisation : comment je procède

J’organise un atelier de 60–90 minutes avec product, design, développement et un représentant commercial ou customer success. Déroulé type :

Le secret : garder l’atelier court et focalisé sur le top backlog (pas la totalité des tickets). On itère régulièrement.

Comment gérer l’incertitude et les expérimentations

Quand la confiance est faible mais le potentiel élevé, je préfère prioriser des expérimentations à faible coût : proof-of-concept, prototypes UX, tests A/B, ou même interviews clients. Ces actions permettent de monter la confiance avant d’embarquer un development cost plus important.

Mes outils et templates préférés

Selon la taille de l’équipe, j’utilise :

Parfois, un simple tableur partagé suffit pour structurer le scoring quand on débute.

Exemples concrets

Voici deux cas rapides tirés de mon expérience :

Indicateurs à suivre après la livraison

Prioriser, ce n’est pas un acte unique. Après chaque livraison, je mets en place un suivi minimal :

Avec un peu de discipline, ces critères transforment la priorisation : des débats plus courts, des décisions documentées et un backlog qui sert vraiment les objectifs du produit. Si vous voulez, je peux vous fournir un template Notion/Google Sheets avec le système de scoring prêt à l’emploi pour commencer directement.